| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- 다익스트라

- 이진탐색

- Dijkstra

- two pointer

- 스토어드 프로시저

- DP

- union find

- Trie

- Hash

- Brute Force

- SQL

- binary search

- 그래프

- MYSQL

- Two Points

- String

- Stored Procedure

- Today

- Total

codingfarm

2. 베이시언 결정 이론 본문

AI가 판단하는 방법

1.패턴에서 특징벡터 X를 추출한다.

2.X라는 조건하에 $w_i$가 발생했을 확률을 구한다.

3.가장 큰 확률을 지닌 부류로 분류한다.

입력으로부터 특징 $X$를 추출했을때 부류 $w_1~w_8$중 어디로 선별해야할지를 결정해야한다.

그러기 위해선 모든 부류에 대한 $p(w_i|X)$를 계산해서 제일 확률이 높은 결과를 선택하면 된다.

$p(w_i|x)$ : $x$라는 조건이 주어젔을때 부류 $w_i$가 발생할 확률(사후 확률)

즉, $x$를 $w_i$로 분류할 확률이다.

2~3장의 핵심주제

사후 확률 $P(w_i|x)$의 추정

- 구하기 어려운가?(그림 1.6을 보고 생각해보자.)

- 왜 어려운가?

- 어떻게 추정하나?

2.1 확률과 통계

2.1.1 확률 기초

주사위

- 주사위를 던졌을 때 3이 나올 확률 $P(X=3) = \frac{1}{6}$

- X를 랜덤변수라 부른다

- 이 경우 X는 이산값을 가진다.

사람 키

- 이 경우 X는 연속값이다.

패턴 인식에서는 특징 각각이 랜덤 변수에 해당한다.

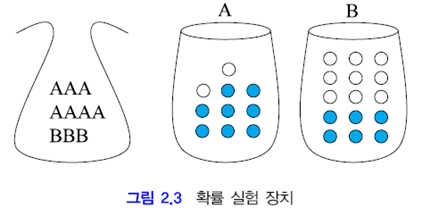

확률 실험

예를 통해 베이즈정리와 사전확률, 우도, 사후 확률을 이해한다.

주머니에서 카드를 뽑아 카드에 적힌 상자에서 공을 뽑아 색을 관찰한다.

랜덤변수 : $X\in\{A,B\},\;Y\in\{blue, white\}$

- 상자 A가 선택될 확률은?

- $P(X=A)=P(A)=\frac{7}{10}$

- 상자 A에서 하얀공이 뽑힐 확률은?

- 조건부 확률 $P(Y=white|X=A)=P(white|A)=\frac{2}{10}$

- 상자는 A이고 공은 하양이 뽑힐 확률은?

- 결합확률 $P(A, white) = P(white|A)P(A) = \frac{2}{10}\frac{7}{10}=\frac{7}{50}$

- 하얀 공이 나올 확률은?

- 주변 확률 $P(white)=P(white|A)P(A)+P(white|B)P(B)=\frac{2}{10}\frac{7}{10}+\frac{9}{15}\frac{3}{10}=\frac{8}{25}$

독립(independant) : 두 랜덤변수가 서로에게 영향을 못 미칠 경우

두 랜덤변수가 독립이면 둘중 무엇이 먼저 일어나더라도 영향이 없다.

P(X,Y)=P(X)P(Y)이면 X와 Y는 독립이다

P(X) 를 사전확률(prior probability)이라 부른다

|

베이스정리 $P(X,Y) = P(Y,X)$ $P(X)P(Y|X) = P(Y)P(X|Y)$ $\displaystyle P(X|Y) = \frac{P(Y|X)P(X)}{P(Y)} = \frac{우도\cdot사전확률}{P(Y)}=사후확률$ |

Q.하얀공을 뽑았는데 그 공이 A와 B중 어디서 나온 확률이 더 큰가?

$P(A)P(white|A)$ VS $P(B)P(white|B)$

둘의 크기를 비교하면 된다.

사건 Y : 공을 뽑는 경우

공을 뽑았는데 그게 A에서 나온경우와 B에서 나온경우로 나누어 생각하면 된다.

$P(Y)=P(Y|A)P(A)+P(Y|B)P(B)$

$\displaystyle P(Y)=\sum_XP(Y|X)P(X)$

이제 $P(A|하양)$과 $P(B|하양)$을 계산할 수 있다.

$\displaystyle P(A|white) = \frac{P(white|A)P(A)}{P(white)}=\frac{(2/10)(7/10)}{(8/25)}=0.4375$

$\displaystyle P(B|white) = \frac{P(white|B)P(B)}{P(white)}=\frac{(9/15)(3/10)}{(8/25)}=0.5625$

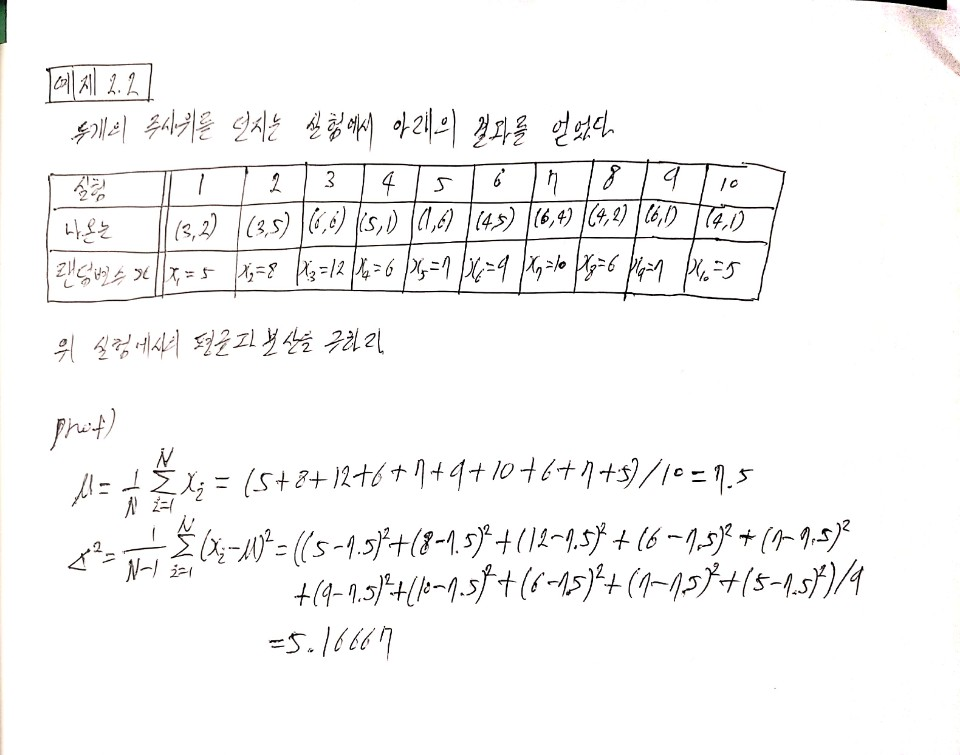

2.1.2 평균(mean)과 분산(variance)

확률 밀도 함수 $P(x)$가 주어질 경우

$이산\;확률\;분포\left\{ \begin{array}{l l} \mu=\displaystyle \sum_xxP(x) \\ \sigma^2=\displaystyle \sum_x(x-\mu)^2P(x) \end{array} \right. $

$연속\;확률\;분포\;\left\{\begin{array}{l l}

\displaystyle \mu=\int_{-\infty}^{\infty}xP(x)dx\\

\displaystyle \sigma^2=\int_{-\infty}^{\infty}(x-\mu)^2P(x)dx \end{array}\right.$

확률 분포는 모르고 샘플 집합만 주어진 경우

$\displaystyle 샘플\;집합\left\{\begin{array}{l l}

\displaystyle \mu = \frac{1}{N}\sum_{i=1}^{N}x_i \\

\displaystyle \sigma^2=\frac{1}{N-1}\sum_{i=1}^{N}(x_i-\mu)^2 \end{array} \right.$

$N\rightarrow\infty$가 되면 실제 확률 분포와 같아진다.

$\mu$과 $\sigma^2$를 알면 표준 정규 분포를 구할수 있다.

|

랜덤 변수가 여러개인 경우

$X=(x_1, x_2,...,x_d)^T$

$\mu=(\mu_1, \mu_2,...\mu_d)^T$

$\displaystyle 이산\;확률\;분포\;\mu=\sum_XXP(X)$

$\displaystyle 연속\;확률\;분포\;\mu=\int_{R^d}XP(X)dX$

$\displaystyle 샘플\;집합\;\mu=\frac{1}{N}\sum_{i=1}^{N}X_i$

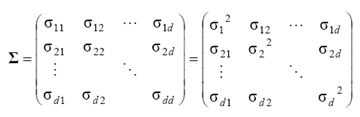

분산 행렬 $\Sigma$

분산행렬 $\Sigma$는 대칭행렬이다.

d : 입력벡터의 차원 수(특징의 갯수)

$\left.\begin{array}{l l}

\displaystyle 이산\;확률\;분포\;\Sigma=\displaystyle \sum_X(X-\mu)(X-\mu)^TP(X)\\

\displaystyle 연속\;확률\;분포\;\Sigma={\displaystyle\int}_{R^d}(X-\mu)(X-\mu)^TP(X)dX\\

\displaystyle 샘플\;집합\;\Sigma=\frac{1}{N-1}\sum_{i=1}^{N}(X_i-\mu)(X_i-\mu)^T

\end{array}\right.$

$\sigma_{ij}$ : $x_i$와 $x_j$의 비례관계

큰값 : 영향이 크다

작은값: 영향이 작다

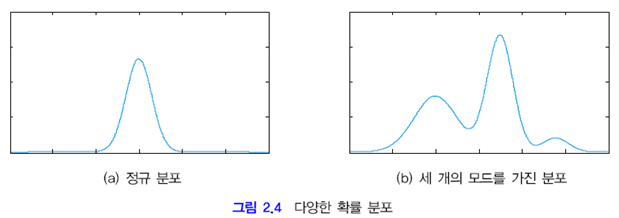

2.1.3 확률 분포의 표현과 추정

이산인 경우

- 차원의 저주

- 변수의 수가 d이고 각 변수가 q개의 구간을 가진다면 $q^d$에 비례하는 메모리가 필요

- 하지만 평균벡터$\mu$와 공분산행렬$\Sigma$을 알면 정규 분포로 근사화 해서 차원의 저주를 피할 수 있다.

- 하지만 우측의 형태처럼 모드가 여러개인 정규분포는 간단히 정규화 할 수 없다.

연속인 경우

- 일정한 형태를 가는 상황

- 그렇지 않은 상황

2.2 베이시언 분류기

앞절에서 배운 확률과 통계의 지식으로 분류기를 설계해보자.

2.2.1, 2.2.2: 부류가 2개인 상황의 이진 분류기를 설계한다.

2.2.3 : M부류에 대한 분류기

훈련집합 : $X=\{(x_1,t_1),(x_2,t_2),...(x_N,t_N)\}$

$x_i$ : i번째 샘플의 특징벡터

$t_i$ : x_i가 속하는 부류표지(class label)

이진부류의 경우 : $t_i \in \{w_1,w_2\}$

M부류의 경우 : $t_i \in \{w_1,w_2,...,w_M\}$

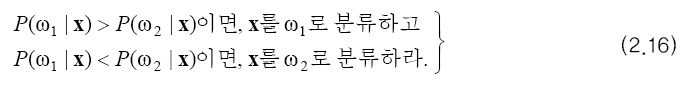

2.2.1 최소 오류 베이시언 분류기

주어진 특징 벡터 x에 대해 '가장 그럴듯한'부류로 분류

(2.16)에서 사후확률$P(w_1|x)$는 직접 구할 수 없다.

(복잡한 입력X가 만드는 공간에 대한 확률을 구하기는 불가능에 가깝다)

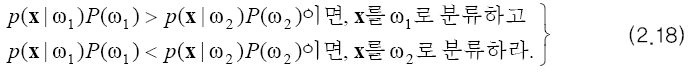

베이스 정리에 의해 사후 확률을 우도와 사전확률로 대체한다.

우리가 원하는것은 사후확률간의 대소관계이다. P(X)는 모든 부류에 대해 다 같게 나오므로 무시해ㅗ된다.

우도와 사전확률은 훈련집합으로 계산이 가능하다.

$P(w_i)=\frac{n_i}{N}$ ($n_i$ : $w_i$에 속하는 샘플의 수)

$P(X|w_i)$ : 3장에서 배운다(지금은 안다고 가정)

이제 분자끼리의 대소관계로 최소 오류 베이시언 분류기(minimum error Baysian classifier)를 정의 할 수 있다.

특수한 경우에서 (2.18)을 해석하면

- 사전확률이 0.5이면 우도만으로 분류 가능

- $P(w_1)>>P(w_2)$이면($w_1$샘플이 $w_2$보다 월등히 많으면) 사전 확률이 의사 결정을 주도 한다.

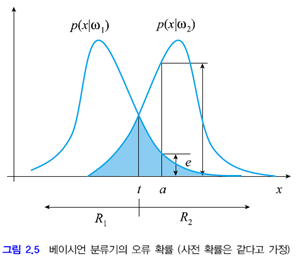

오류 확률(error probability)

베이시언 분류기가 범하게 될 오류를 예측 할수 있다.

오류란 주어진 입력을 잘못 분류하는것을 말하며

가령,

$w_1$로 분류되어야할 입력$x$를 $w_2$로 분류하거나

$w_2$로 분류되어야할 입력$x$를 $w_1$로 분류하는것을 말한다.

$P(w_1)=P(w_2)=0.5$일때의 부류조건부확률은 아래와 같다.

t를 기준으로 $P(X|w_1)$과 $P(X|w_2)$의 대소관계가 명확히 나누어 진다.

t를 기준으로 왼쪽 영역의 입력은 $w_1$으로, 오른쪽 영역의 입력은 $w_2$로 분류하는것이 옳다.

하지만 모든 구역 내에서 임의의 $P(X|w_i)$를 선택할 확률이 존재한다.

즉, $P(X|w_1)$이 $P(X|w_2)$보다 큰 $R_1$ 지역에서도 $P(X|w_2)$를 선택할 확률이 존재한다. 그 확률을 오류확률이라 한다.

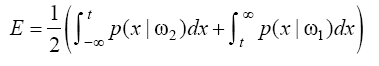

그러므로 2개 부류에 대해서 오류가 발생할 확률은 아래와 같다.

$$E=\int_{-\infty}^{t}p(x|w_2)p(w_2)dx+\int_{t}^{\infty}p(x|w_1)p(w_1)dx$$

x=a인 지점에서$P(X|w_1)<P(X|w_2)$이므로 이때 베이시언 분류기는 X를 $w_2$로 분류한다.

하지만 x=a인 샘플중에 $w_1$에 속하는것이 e만큼 발생한다

실제 오류확률 = $P(X|w_1)P(w_1)=\frac{e}{2}$

즉, 베이시언 분류기의 오류확률은 위 그림에서 칠한부분의 $\frac{1}{2}$가 된다

$P(X|w_1)$과 $P(X|w_2)$이 주어지더라도 잘못된 선택에 의한 실질적인 손실은 다를 수 있다. 가령 $w_1$대신에 $w_2$를 선택하는 실수가 그 반대의 경우보다 크다면 $w_2$를 선택하는 실수를 저지를 확률을 줄이기 위해 즉, $w_1$를 선택하는 오류 확률을 늘리기 위해서 t의 값을 고쳐줘야한다.

임계값 t를 왼쪽으로 살짝 옮기면 $P(X|w_2)$의 오류 확률 범위가 줄어드며 $P(X|W_1)$의 오류 확률 범위가 늘어난다. 오류확률은 연한 파란색 면적의 $\frac{1}{2}$만큼 증가한다.

t의 범위가 달라짐에 다라 적분구간도 수시로 변함에 주목하라.

2.2.2 최소 위험 베이시언 분류기

2.2.1절의 베이시언 분류기는 오류확률의 최소화를 목표로 둔다.

하지만 오류확률의 기준이 명확하지 못한 경우들이 있다.

- 정상인과 암환자 분류

- 과일을 상품과 하품으로 분류

$C_{ij}$ : X를 $w_i$가 아닌 $w_j$로 분류할때의 손실(즉, $w_i$가 되어야할 $X$를 $w_j$로 분류할때의 손실)

$C_{ii}=0$

손실행렬(loss matrix)

$w_i$에 속한 샘플 X에 의한 손실 $d_i$ 추정하기

$w_1$으로 분류되어야 할 $R_1$에 속하는 X가 있을때, X가 발생할 확률을 $P(X|w_1)$이며 이때의 손실은 $C_{11}$이다. 따라서 X에 의한 손실의 기대치는 $C_{11}P(X|w_1)$이다.

$w_1$으로 분류되어야 할 $R_2$에 속하는 X가 있을때, X가 발생할 확률을 $P(X|w_2)$이며 이때의 손실은 $C_{12}$이다. 따라서 X에 의한 손실의 기대치는 $C_{12}P(X|w_2)$이다.

$d_i$ : $w_i$에 속하는 X를 분류할때 나오는 손실의 기대치, $w_i$에 속하는 X를 분류하는 방법은 $w_1$과 $w_2$ 둘중 하나로 분류하는 것이다. 그러므로 주어진 부류 모두로 분류 했을때 나오는 손실을 더하면 얻을 수 있다.

$\displaystyle d_1 = c_{11}{\int}_{R_1}P(X|w_1)dX + c_{12}{\int}_{R_2}P(X|w_1)dX$

$\displaystyle d_2 = c_{21}{\int}_{R_1}P(X|w_2)dX + c_{22}{\int}_{R_2}P(X|w_2)dX$

$\displaystyle d_i=\sum_{j=1}^{N}{\int}_{R_j}C_{ij}P(X|W_i)dx$

D : 모든 부류를 고려한 평균 손실

$d_i*w_i$의 사전확률

$\displaystyle D=\sum_{i=1}^{2}\int_{R_i}\left(\sum_{j=1}^{2}C_{ji}P(X|W_j)\right)dX$

$\displaystyle D=\sum_{i=1}^{N}d_i$

$q_i$ : X를 i에 분류할때의 손실

$\displaystyle q_1=c_{11}P(X|w_1)+c_{21}P(X|w_2)$

$\displaystyle q_2=c_{12}P(X|w_1)+c_{22}P(X|w_2)$

$\displaystyle q_i=\sum_{j=1}^{N}c_{ji}P(x|w_j)P(w_j)$

그러면 평균손실 D를 최소화 하기 위한 특정공간을 어떻게 $R_1$과 $R_2$로 나눌것인가?

특정 공간을 $R_1$과 $R_2$의 2개구역으로 나눈다

$\left.\begin{array}{} 특정\;공간을\;R_1과\;R_2 \\2개\;구역으로\;나눈다\end{array}\right. =

\left.\begin{array}{} 어떤\;X를\;R_1과\;R_2중\\어디에\;소속시킬지\;결정한다\end{array}\right.

$

D를 최소화 시키는 결정규칙은 아래와 같다

| $q_1<q_2$이면 X를 $w_1$으로 분류하고, $q_1>q_2$이면 X를 $w_2$로 분류하라 |

즉, 손실이 적은쪽의 $w_i$를 선택하면 D를 최소화 할 수 있다.

$q_i$간의 대소관계를 새로 고쳐쓰면 아래와 같이 우도비 결정규칙(likelihood ratio decision rule)을 정의할수있다.

위 식의 특이케이스

- $c_{ii}=0$으로 둔다

- 사전확률 $P(w_i)$가 같다고 한다.

그러면

X를 $P(X|w_1)>P(X|w_2)\frac{c_{21}}{c_{12}}$이면 $w_1$으로 분류,

그리고 $P(X|w_1)<P(X|w_2)\frac{c_{21}}{c_{12}}$이면 $w_2$으로 분류한다.

$c_{12} = c_{21}$이면 최소위험 분류기는 최소오류분류기와 같다.

$c_{12}$가 커지면 2로 분류할 확률을 낮추기 위해 경계 t를 오른쪽으로 옮긴다.

ex) 정상이라는 확신이 크지 않으면 암환자로 분류하는게 손실이 적다. 정상인을 암환자로 분류해서 나오는 쓸모없는 검사의 손실보다. 암환자를 정상인으로 분류하면 나오는 치료시기를 놓처 죽음에 이를 수 있는 손실이 더 크기 때문

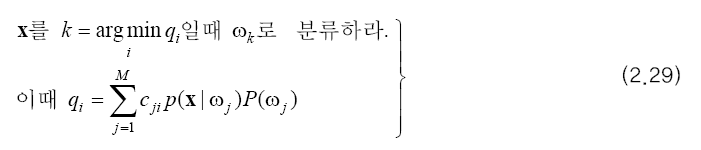

2.2.3 M부류로 확장

이제 부류를 2개에서 M개로 확장한다.

부류가 2개 일때의 분류기를 다시보자

이 규칙을 M개로 확장하면 아래와 같다.

사후 확률을 사전확률과 우도로 바꾸면

위험을 고려한 M부류 분류기를 유도한다.

$$D = \sum_{i=1}^M\int_{R_i}(\sum_{j=1}^{M}C_{ji}P(X|w_j)P(w_j))dx$$

$$D = \int_{R_1}(\sum\_{j=1}^{M}C_{j1}P(X|w_j)P(w_j))dx +...+\int_{R_M}(\sum_{j=1}^{M}C_{jM}P(X|w_j)P(w_j))dx$$

$$q_k = \sum_{j=1}^{M}C_{jk}P(X|w_j)P(w_j)$$

$q_k$ : k로 분류할때의 총 손실

평균손실 D를 최소화 하기 위해선 X를 $R_1~R_M$중 어디에 소속 시킬지 결정해야한다.

X를 $R_i$에 소속시키면 $q_i$만큼의 손실이 발생하므로 D를 최소화 시킬 규칙은 아래와 같다.

| $d_i$ | $q_i$ |

| $w_i$에 속해야할 $x$를 분류할때의 총 손실 | $x$를 $w_i$에 분류할때의 손실 |

| $\displaystyle d_i=\sum_{j=1}^{N}{\int}_{R_j}C_{ij}P(X|W_i)P(W_i)dx$ | $\displaystyle q_i=\sum_{j=1}^{N}c_{ji}P(x|w_j)P(w_j)$ |

M개의 부류에 대해 평균 손실 D는 아래와 같다.

$$D = \sum_{i=1}^{M}d_iP(w_i)=\sum_{i=1}^{M}\int_{R_i}q_i$$

| 최소 오류 베이시언 분류기 | 최소 위험 베이시언 분류기 |

|

$x$를 $k=\underset{i}{argmax}P(w_i|x)$ 일때 $w_k$로 분류한다 |

$x$를 $=\underset{i}{argmin} \; q_i$일때 $w_k$로 분류한다 |

2.3 분별함수(Discliminant Function)

M부류 최소 오류 베이시언 분류기와 M 부류 최소 위험 베이시언 분류기는 서로 다른 수식과 의의를 가진다.

하지만 아래처럼 동시에 쓸 수도 있다.

$g_i(x)$ : 분별함수(discliminant function), X를 서로 다른 부류로 분별하는데 필요한 정보를 준다.

argmin을 argmax로 통일하기 위해 최소 위험 분류기의 항을 역수로 취했다.

위와 같은 표현을 통해 서로 다른 부류기를 같은 틀 내에서 해석할 수 있다.

분별 함수 표현의 장점

f(.)가 단조 증가(monotonically increasing)이면 $P(X|w_i)P(w_i)$ 대신

$g_i(x)=f(P(X|w_i)P(w_i))$를 사용해도 대소관계는 유지되므로 같은 결과를 얻는다.

패턴인식에서 f(.)는 주로 log가 쓰인다

-곱셈, 나눗셈을, 돗셈 뺄셈으로 바꾸어 수식 전개에 유리

-값의 규모가 커져서 수치 오류에 둔감하다.

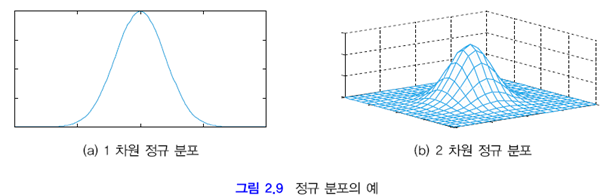

2.4 정규 분포에서 베이시언 분류기

지금까지 배운 분류기의 특징

- 패턴 X가 입력되면 M개의 부류에 대해 사후확률 $P(w_i|x)$를 계산해야한다. 그리고 베이스 정리에 따라 $P(X|w_i)P(w_i)$로 변환한다.

- $P(X|w_i)$의 계산을 위해선 평균$\mu$과 분산$\sigma^2$을 이용한 정규분포(normal distribution) 혹은 가우시안 분포(Gaussian Distribution)을 통해 계산한다.

정규분포가 가지는 특성

- 정규 분포가 현시세계와 잘 맞는 경우가 많다.

- ex) 키와 몸무게는 정규분포에 가깝다

- 평균$\mu$과 분산$\sigma^2$이라는 2개의 매개변수로 확률분포가 표현된다. 즉, 훈련집합으로 정규분포를 추정할때는 평균과 분산만 찾으면 된다.

- 수학적으로 매력적인 특성이 많다.

- ex) 두개 부류의 공분산 행렬이 모두 단위행렬 이면 두 부류의 결정 경계는 직선이다.

2.4.1 정규분포와 분별함수

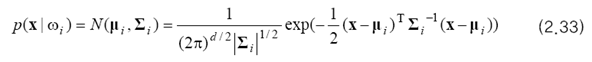

우도$P(X|w_i)$가 정규분포를 따른다는 가정하에 베이시언 분류기의 특성을 해석해보자.

정규분포

$\Sigma_i$ : 입력 $x_i$가 평균$\mu$로 부터 얼마나 멀리 있는가?

$\Sigma$ : 전체 입력들이 평균으로 부터 흩어진 정도가 어느정도인가?

부류$w_i$가 평균 벡터$\mu_i$와 공분산 행렬 $\Sigma_i$를 갖는 정규분포를와 같다고 가정한다.

그러면 $w_i$의 우도는 아래와 같다.

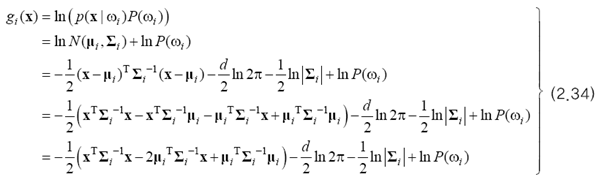

로그를 취하여 분별함수를 만들면

$g_i(x)$는 변수x에 대한 2차식이다.

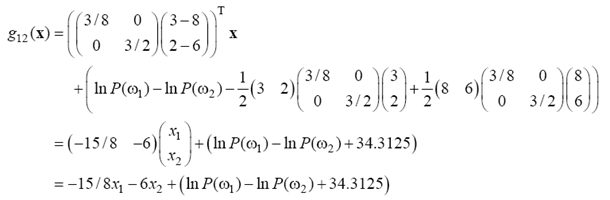

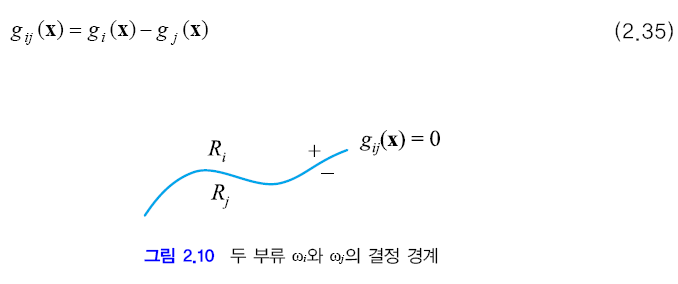

두 부류 $w_i$와 $w_j$의 결정경계(decision boundary)에 대해 알아보자.

어떤점 $x$가 이 경계상에 있다면 $g_i(x)=g_j(x)$를 만족해야 한다. 이때 $g_{ij}(x)$를 아래와 같이 정의한다면 이 점은 $g_{ij}(x)=0$ 이 된다.

이제 결정 경계가 갖는 모양에 대해서 설명하겠다.

2.4.2절 에서는 모든 부류가 같은 공분산 행렬을 가질경우에, 2.4.3절 에서는 그렇지 않은 경우로 나누어 설명하겠다.

2.4.2 선형 분별

모든 부류의 공분산 행렬이 같은경우

$\Sigma_i = \Sigma$로 표기 가능하며

분별함수에서 i에 무관한 항은 소거 가능하다(분류는 분별 함수의 값 바체가 아니라 비교를 통해 이루어 지므로)

이 식에서 2차항인 $x^T\Sigma^{-1}x$가 사라짐에 주목하라

결국 분별함수 $g_i(x)$는 1차식이 된다.

이 식을 선형 방정식 형태로 다시 작성하면 아래와 같이 선형식이 된다.

식 2.35에 2.37을 대입하면

새롭게 얻은 결정경계식 $g_{ij}(x)$가 어떤 모양이 되는지를 살펴보자.

결정 경계상의 점 x는 $g_{ij}(x)=0$이어야 하며, $g_{ij}(x)$는1차식이므로 결정경계가 초평면을 이룸을 알수있다.

또한 공분산행렬$\Sigma$가 $\sigma^2I$인 경우에는정규 분포의 등고선이 원형을 이루며 결정 경계는 아래와 같다.

특히, 결정 직선이 $\mu_i-\mu_j$에 수직을 이룬다.

$g_{if}(x)=\underbrace{\frac{1}{\sigma^2}(\mu_i-\mu_j)^T}_{w}\left(x-\underbrace{\left(\frac{1}{2}(\mu_i+\mu_j)-\frac{\sigma^2(\mu_i-\mu_j)}{{\|\mu_i-\mu_j\|}^2}ln\frac{P(w_i)}{P(w_j)}\right)}_{x_0}\right)

$

$=w^T(x-x_0)$

위와 같은 선형 분류기를 만드는 방법을 선형 분별 분석(linear discriminant analysis; LDA)라 부른다

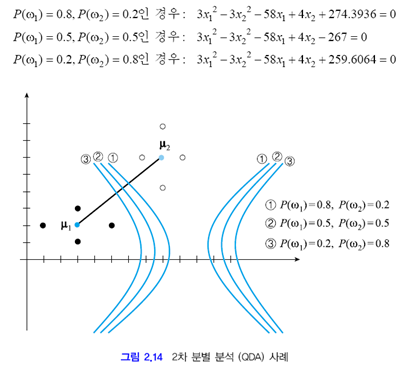

2.4.3 2차 분별

이제 모든 부류의 공분산 행렬이 다 같다는 제약이 없다고 하자.

그때의 상황은 아래와 같다.

이제 식 (2.34)에서 무시 가능한 항은 $(d/2)ln2\pi$ 뿐이다. 이 항을 무시(??)하고 분별함수를 다시쓰면 식(2.40)과 같다.

$g_{ij}(x) = g_i(x)-g_j(x)$이므로 $g_{ij}(x)$는 2차 식에서 2차 식을 밴 것이다.따라서 $g_{ij}(x)=0$을 만족하는 걸정 곡선은 2차 곡선이 된다. 경우에 따라 쌍곡선도 되고 타원도 된다.

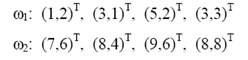

예제2.6

예제2.5를 살짝 고쳐 재활용 하자. $w_1$의 분포는 그대로 두고 $w_2$의 분포를 그림2.14와 같이 바꾼다.

이제 분별 함수를 통해 결정 곡선을 유도해보면

2.4.4 최소 거리 분류기

이때까지 LDA를 이용한 선형 분류기와 QDA를 이용한 2차 분류기를 만드는 방법을 살펴보았다.

이제 이 분류기들을 다른 시각으로 해석해보자.

수식 유도의 편의를 위해 두 부류의 사전 확률과 공분산 행렬을 같다고 가정한다. 그리고 식 (2.34)를 다시 쓰면 아래 식을 얻을 수 있다.

식 (2.30)에 따르면 베이시언 분류기는 (2.41)의 $g_i(x)$의 값이 가장 큰 부류로 분류한다.

(2.41)을 최대로 한다는것은 (2.42)를 최소로 한다는 것이다. (2.42)는 $x$에서 $\mu_i$까지의 마할라노비스 거리(Maahalanobis distance)이다.

(2.42)에서 $\Sigma=\sigma^2I$인 경우는 상수로 볼수 있으므로 무시하면 식(2.43)이 된다.

예제 2.7 - 마할라노비스 거리

예제2.5를 다시 활용한다. 그림 2.15에서 $x=(8,2)^T$라 하자. 확률 분포를 모드 무시하고(또는 두 확률 분포에서 \mu_1과 \mu_2의 좌우에 있는 두 점을 1만큼 가까이 당겨 다시 배치함으로써 $\Sigma = \sigma^2I$인 사오항을 만들어) $x$에서 $\mu_1$과 $\mu_2$까지의 유클리디언 거리를 계산하면 각각 5.0과 4.0이 되어 $x$는 $mu_2$에 더 가깝다.

이제 그림 2.15의 확률 분포에 따라 마할라노비스 거리를 계산해 본다.

그림 2.15에서 마할라노비스 거리에 대한 직관적인 해석이 가능하다. 정규분포 $N(\mu_1,\Sigma)$와 $N(\mu_2,\Sigma)$는 가로로 넓게 퍼진 반면 세로 방향으로는 조밀하다. 따라서 가로 방향으로 놓인 점까지는 실제보다 가깝고 세로방향은 실제보다 멀게 해석하는것이 합리적이다. 결국 $N(\mu_1,\Sigma)$에게 가로방향에 놓여 있는 x는 그리 멀지않지만, $N(\mu_2,\Sigma)$에게 세로 방향으로 놓여 있는 x는 더욱 멀게된다.

(2.30)의 베이시언 분류기를 최소 거리 분류기(minimum distance classifier)형태로 제시 하면 (2.44)와 같다.

이 분류기는 모든 부류가 정규 분포를 따르고, 같은 사전 확률과 같은 공분산 행렬을 갖는다는 가정하에 적용 가능하다.

(2.30)은 확률을 최대로 해야 하므로 armax를 사용하지만 (2.44)는 거리를 최소로 해야 하므로 argmin을 사용했음에 주목하라.

2.5 베이시언 분류의 특성

- 비현실성을 내포하고 있다. 일반적인 확률 분포를 사용하려 하면 차원의 저주가 발생한다. 정규 분포를 가정하면 실제 확률 분포와 차이가 발생한다.

- 1.의 비현실성을 무시하고, 실제 확률 분포를 안다고 가정하면 베이시언 분류기는 오류율 측면에서는 최적이다. 이 최적성을 수학적으로 완벽하게 증명할 수 있다.

- 베이시언 분류기는 M개 부류 각각에 대해 그에 속할 확률을 출력한다. 즉 (2.30)의 베이시언 분류기에서 $g_j(x)$를 확률로 해석할 수 있다. 따라서 이 확률을 신뢰도 값으로 삼아 후처리 등에 유용하게 활용할 수 있다.

베이시언 분류기를 만들기 위해서는 사전 확률$P(w_i)$과 우도$P(X|w_i)$를 측정해야한다. 이 과정에서 차원의 저주가 발생한다. 하지만 특징들이 모두 독립이라면 차원의 저주를 피할 방법이 있다. 이 가정하에 우도를 (2.45)와 같이 쓸 수 있다. 이 식에서 $x=(x_1,...,x_d)^T$이다. 이제 각각의 특징이 다른 특징과 무관하게 우도를 추정하여 1차원 배열에 저장할 수 있다. 그들을 모두 곱하면 구하고자 하는 우도가 된다. 이 분류기를 나이브 베이시언 분류기(naive Bayesian classifier)라 부른다.

나이브(naive) 베이시언 분류기

- 특징들이 서로 독립이라는 가정

- 얻는것 : 차원의 저주를 피함

- 잃는것 : 성능저하

2.6 기각 처리

기각(rejection) : 신뢰도가 충분치 않은 경우의 의사결정을 포기하는것. 즉, 확률 값 차이가 충분히 크지 않아 신뢰할 수 없을 경우에 의사결정을 포기한다.

ex) 필기 숫자가 애매한 경우는 분류를 보류하고 사람이 의사결정 하도록 미루는것이 좋다. 가령 꼭지가 작은 6과 0은 분류가 모호하다.

그림 2.16에서 두 부류의 확률 차이가 $Delta$보다 작으므로 기각한다.

진튼 파란색 영역의 면적이 오류율이 되고, 연한 파란색 영역의 면적이 기각률이다.

'AI > 패턴인식' 카테고리의 다른 글

| 3. 확률 분포 추정 - 파젠창(Parzen Window) (0) | 2020.04.10 |

|---|---|

| 3. 확률 분포 추정 - 히스토그램 추정(histogram estimation) (0) | 2020.04.10 |

| 3. 확률 분포 추정 - 최대 우도 추정(Maximum Likelihood Estimation) (0) | 2020.04.10 |

| 3. 확률 분포 추정-개요 (0) | 2020.04.09 |

| 1. 소개 (0) | 2020.01.28 |