| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- Dijkstra

- 이진탐색

- Two Points

- SQL

- binary search

- union find

- Trie

- 스토어드 프로시저

- Hash

- String

- two pointer

- Stored Procedure

- DP

- 다익스트라

- Brute Force

- MYSQL

- 그래프

- Today

- Total

codingfarm

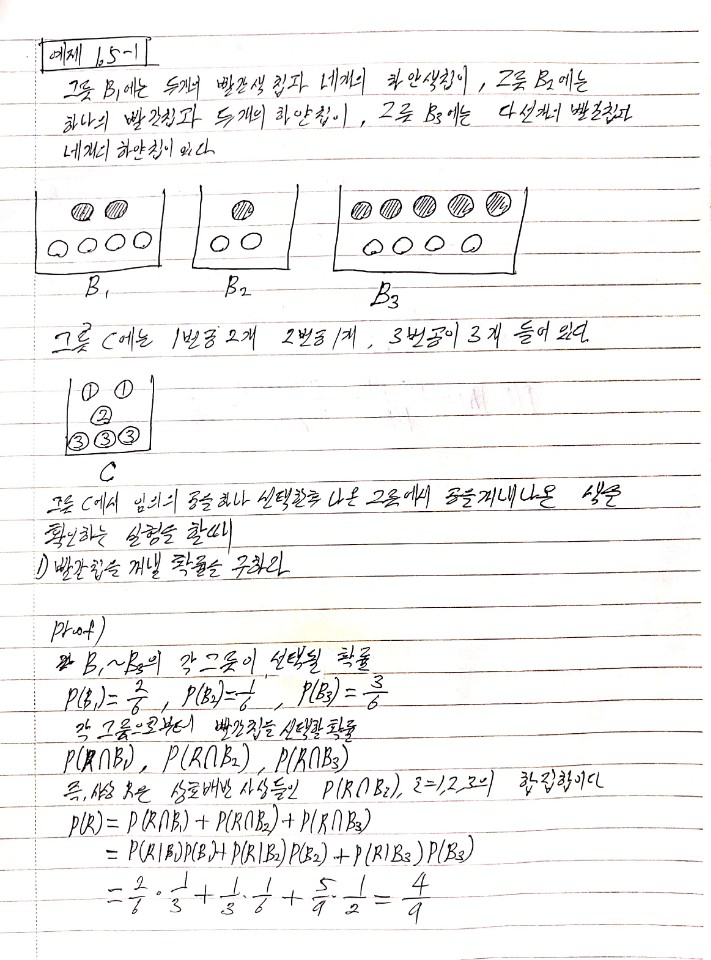

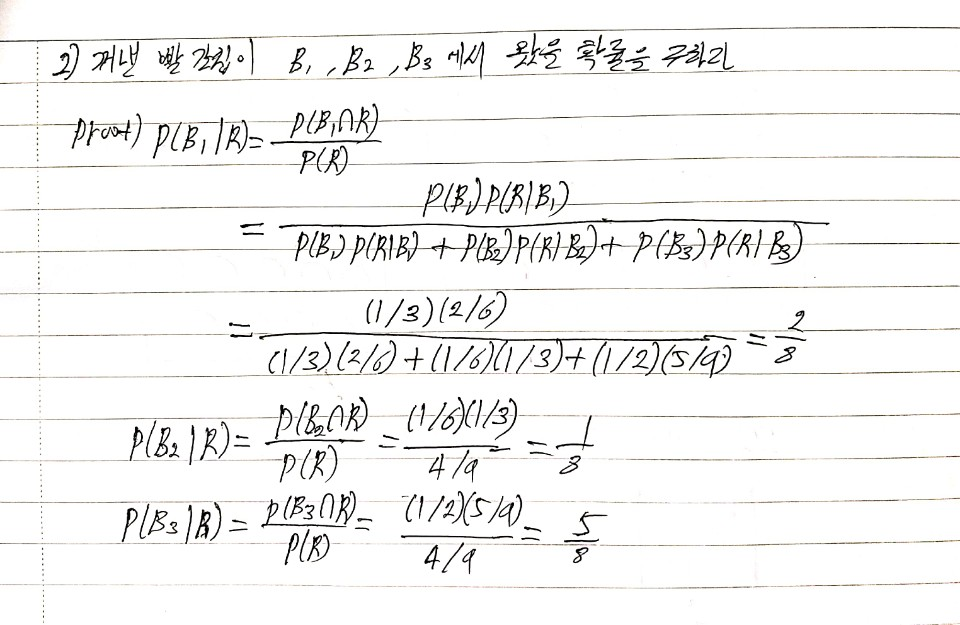

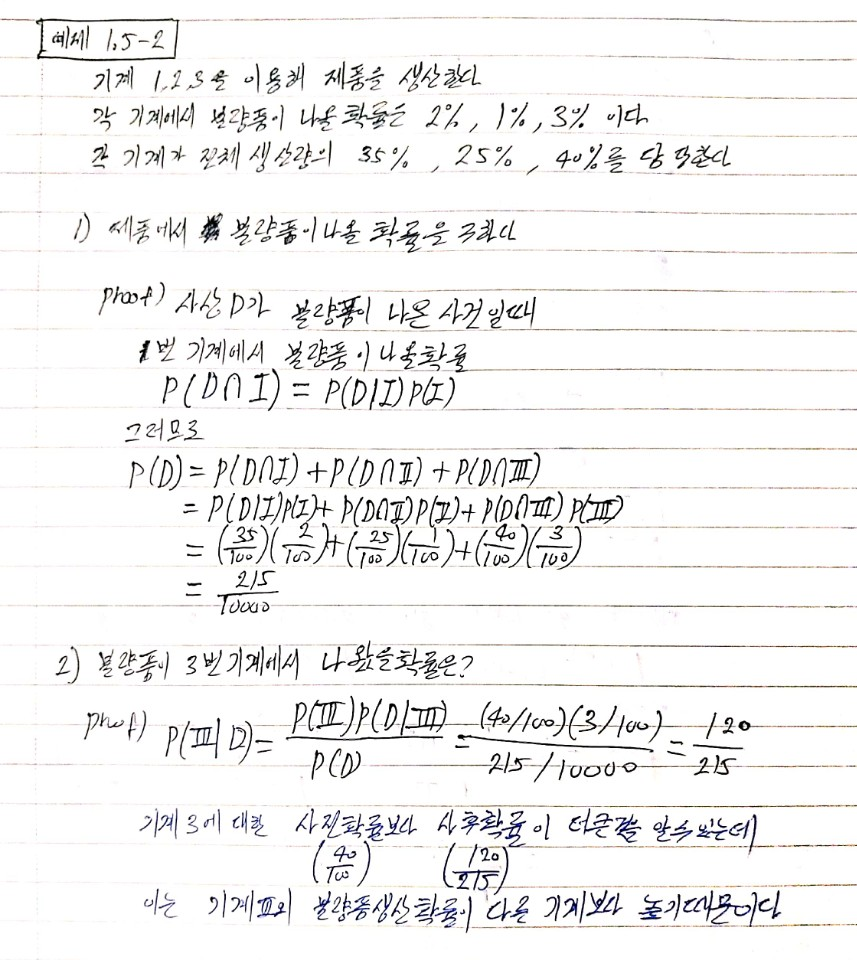

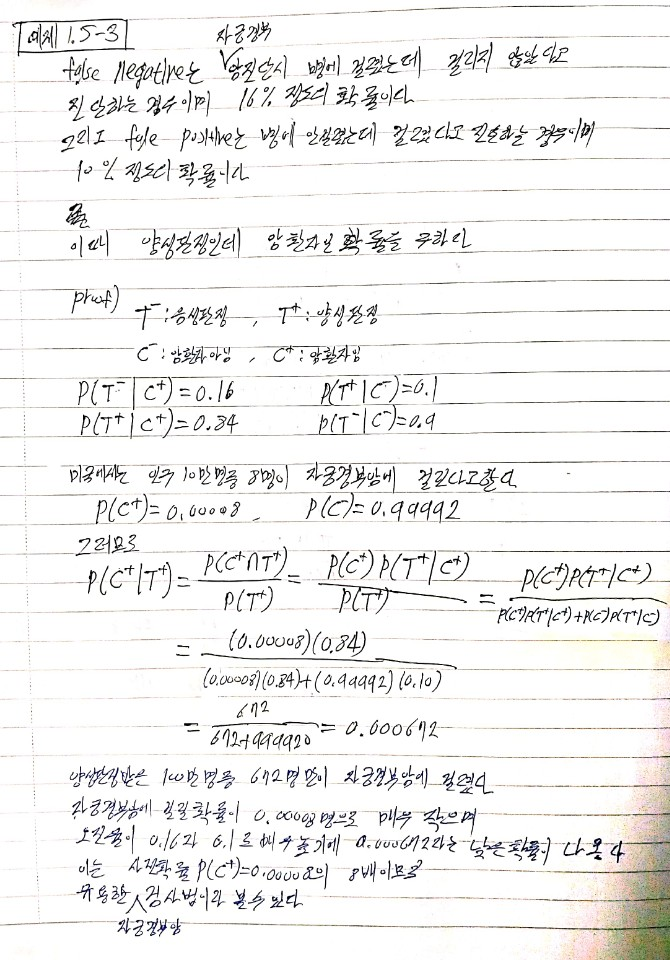

베이즈 정리(Bayes' theorem) 본문

$n$개의 사상 $\{B_1,B_2,\cdots,B_n \}$이 표본공간 $S$의 분할이다.

사상 $A$가 표본공간 $S$의 임의의 사건이라면

$$P(B_i|A)=\dfrac{P(B_i)P(A|B_i)}{\sum_{i=1}^{n}P(B_i)P(A|B_i)}$$

사상 $B_1,B_2,\cdots,B_n$이 표본공간 $S$의 분할(Partition)이라하자.

즉, $S=B_1 \cup B_2 \cup \cdots\cup B_n$ 그리고 $B_i \cap B_j \neq \varnothing,\;\;\; i \neq j$

이때 $B_1, B_2, \cdots, B_m$은 상호 배반(matually exclusively)이며 포괄적(exhaustive)이다.

그러므로

$B_i \cap B_j = \varnothing(i \neq j)$ 그리고 $B_1 \cup B_2 \cup \cdots \cup B_m = S$ 이다.

사상 $B_i$의 사전확률인 임의의 사상 $A$는 $m$개의 상호 배반 사상들의 합집합으로 나타낼 수 있다.

$A = (B_1 \cap A) \cup (B_2 \cap A) \cup \cdots \cup (B_m \cap A)$ 이때 $P(B_i) > 0$ 이다.

따라서

$$\begin{align*}

P(A) &= \sum_{i=1}^{m}P(B_i \cap A)\\

&=\sum_{i=1}^{m}P(B_i)P(A|B_i)

\end{align*}$$

위 식은 전환률의 법칙(law of total probability) 라고 불린다.

만약 $P(A)>0$ 이면

$$P(B_k | A) = \dfrac{P(B_k \cap A)}{P(A)},\;\;\;k=1,2,\cdots,m$$

위 2개의 식을 대입하면

$$P(B_k | A) = \dfrac{P(B_k)P(A|B_k)}{\sum_{i=1}^{m}P(B_i)P(A|B_i) },\;\;\;k=1,2,\cdots,m$$

위 식을 베이즈 정리(Bayes' theorem) 라 한다.

이때

$P(B_k)$ : 사상 $B_k$의 사전확률(prior probability)

$P(B_k|A)$ : 사상 $B_k$의 사후확률(posterior probability)

라고 한다.

'통계학 > 확률론' 카테고리의 다른 글

| 전체 확률 법칙(Law of total probability) (0) | 2020.05.27 |

|---|---|

| 조건부확률(Conditional probability)과 독립사상(independent event) (0) | 2020.05.26 |